Roark发布:重塑Voice AI开发流程,构建可靠性与可见性新标准

Roark平台发布,旨在解决Voice AI开发中的关键痛点,提供端到端的可靠性与可见性解决方案。

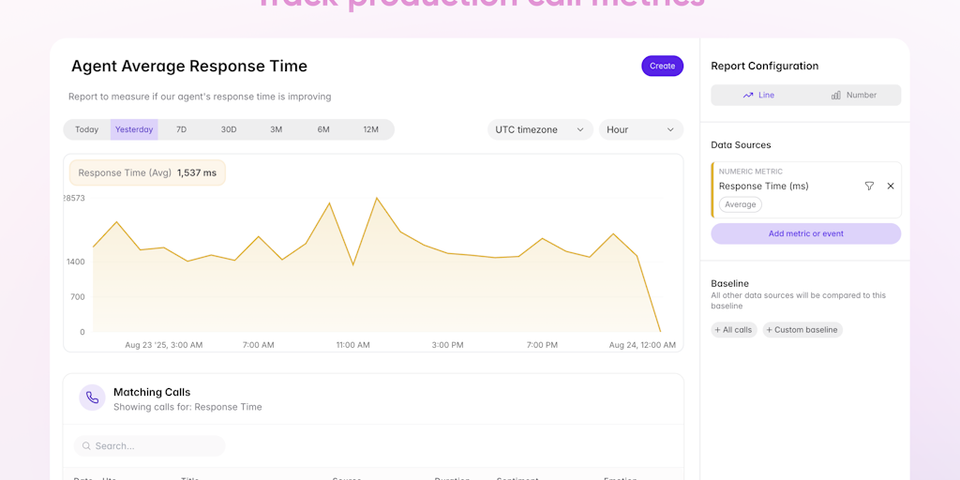

该平台通过捕获超过40项内置通话指标(如延迟、指令遵循度、重复检测、情感分析等)并支持自定义指标,实现对语音AI代理的深度监控与评估。其先进的音频分析模型能识别情绪、声学线索,并根据具体用例优化转录文本。用户可构建定制化仪表板、设置报告调度、配置告警及触发Webhooks,确保团队始终掌握AI代理的运行状态。此外,Roark支持多达15个发言者的通话分析,并提供自动发言者识别。

Roark的另一核心功能是模拟与个性化测试。它支持电话或WebSocket连接的入站/出站代理进行端到端模拟,复现真实客户路径。测试场景以对话图的形式定义,易于扩展至边缘案例或变体测试,确保测试覆盖率反映真实世界的复杂性。平台允许用户通过性别、语言、口音、背景噪音及语音特征(语速、清晰度、非流利语)配置代理个性。更进一步,可叠加情感基调、意图清晰度、确认风格、记忆可靠性等行为特征,甚至构建背景故事,以实现对AI代理在真实世界变量下的压力测试,并能自动从失败的实时通话生成可复现的测试用例。

在集成方面,Roark提供Node.js和Python的SDK及REST API,并原生支持LiveKit、Pipecat、VAPI、Retell和Voiceflow等主流平台,确保了市场上的易集成性。在过去六个月中,Roark已为Radiant Graph、Podium、Aircall和BrainCX等公司处理超过1000万分钟的通话,显著提升了其代理评估和模拟的规模化效率,构建了一个从监控、故障识别、测试生成到持续改进的完整生命周期闭环。

Roark将自身定位为Voice AI领域的QA与可观测性层,为语音AI的稳定性和性能提供坚实保障。

网友讨论