QAT与QAD:AI模型低精度部署的精度守护者

为解决AI模型在部署过程中因低精度量化(如PTQ)导致的精度下降问题,量化感知训练(QAT)与量化感知蒸馏(QAD)技术应运而生。这两种方法在模型训练阶段便引入量化过程的模拟,使模型能够主动适应低精度表示,从而在精度恢复上优于仅依赖后训练量化的PTQ。

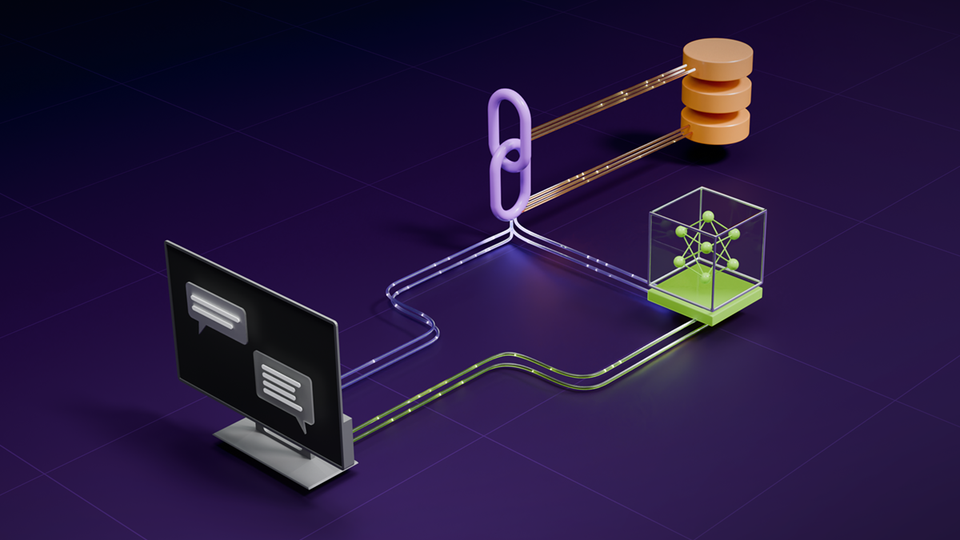

QAT通过在预训练后增加一个量化感知训练阶段,使模型学习处理低精度运算。其核心在于“伪量化”操作,即在正向传播中使用高精度数据类型模拟低精度计算,并将量化误差暴露给损失函数,促使模型适应并恢复精度。虽然QAT可能不优化训练吞吐量,但它能生成高精度推理模型。

QAD则结合了知识蒸馏,利用一个高精度的“教师”模型指导一个低精度的“学生”模型。在训练过程中,学生模型进行伪量化,同时通过蒸馏损失函数对齐教师模型的输出。这种方式能更有效地将量化误差纳入考量,直接调整模型以适应低精度,实现比先蒸馏后量化更高的精度恢复。

NVIDIA的TensorRT Model Optimizer为QAT和QAD提供了原生兼容PyTorch和Hugging Face的API,简化了开发流程。通过调整学习率、训练周期等参数,开发者可高效地应用这些技术。实践表明,即使是原始训练时长的一小部分(如LLMs的1%),也足以通过QAT/QAD显著恢复模型精度。

在实际应用中,QAT和QAD的效果受训练数据、超参数及模型架构影响。例如,在处理包含精细图表和微小数字的复杂视觉问答任务时,NVFP4等格式因其更精细的量化尺度因子,能更好地保留模型细节,显著优于PTQ。这为追求高效且高精度的AI模型部署提供了可行路径。

网友讨论