Pandas性能瓶颈终结者:cuDF赋能GPU加速,代码零改动释放海量算力

数据处理的瓶颈是许多Python开发者的痛点,尤其是在处理大型数据集时。本文聚焦于Pandas库的五大常见性能瓶颈,并提供了CPU端的优化策略及基于NVIDIA cuDF的GPU加速方案。

**核心洞察与关键发现**

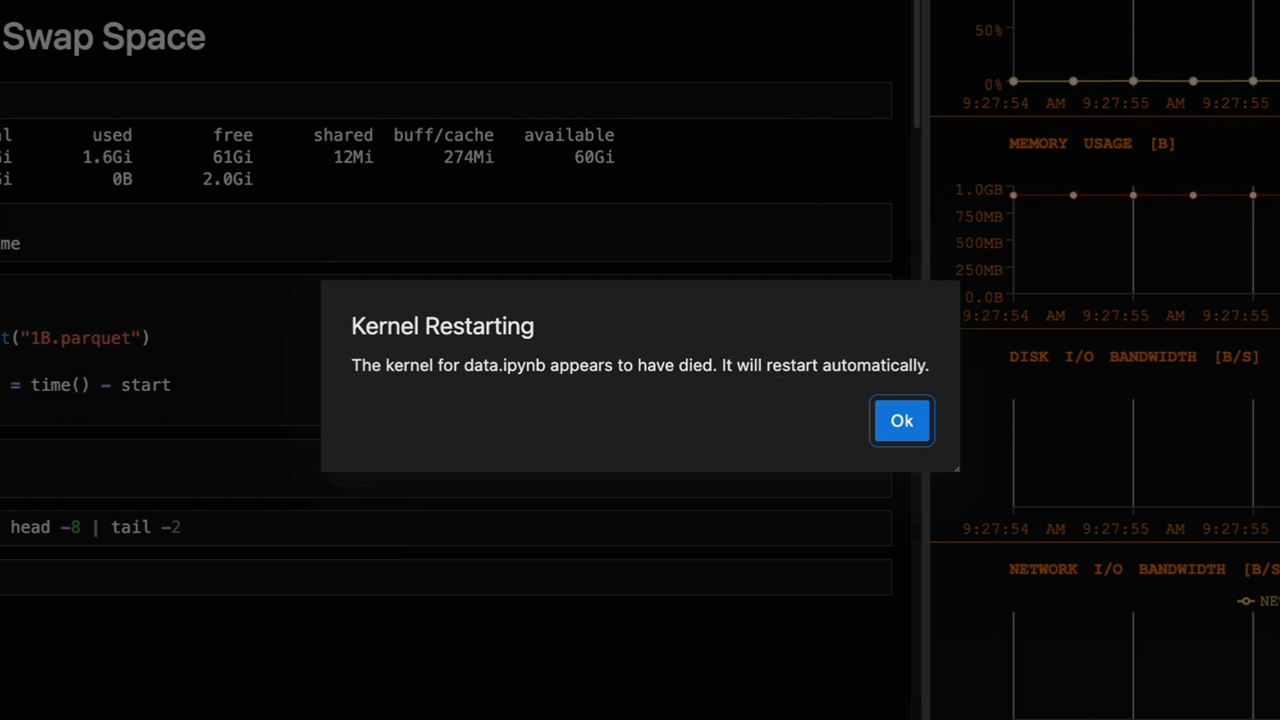

Pandas在CSV读取、数据合并(join/merge)、字符串处理、分组聚合(groupby)以及内存管理方面存在显著的性能瓶颈。原文详细剖析了这些问题,例如`read_csv`的缓慢解析、大尺寸数据合并导致的内存激增和CPU占用过高、字符串列占用的巨大内存、`groupby`操作的CPU密集型特性,以及处理超出CPU内存容量的数据集时遇到的内存错误。针对这些痛点,CPU端的解决方案包括使用`engine='pyarrow'`优化CSV读取、合并前剔除冗余列、利用Pandas的`category`类型以减少字符串内存占用、在`groupby`前过滤数据等。更进一步,NVIDIA cuDF通过提供`cudf.pandas`这一即插即用型加速器,能在不修改现有Pandas代码的前提下,利用GPU的强大并行计算能力,实现数量级的性能提升。用户无需拥有本地GPU,即可通过Google Colab免费使用此加速方案。

**战略分析与趋势预判**

此次发布的`cudf.pandas`加速器标志着数据科学工作流向GPU加速的迁移正在变得前所未有的便捷。它消除了代码重写这一重大障碍,使得数据科学家能够轻松地将其现有的Pandas代码库迁移到GPU上运行,从而大幅缩短数据处理和模型迭代的时间。这不仅提升了个人生产力,也为企业级大数据分析和机器学习模型的开发提供了更高效的基础设施。随着AI和大数据应用的普及,类似的“零代码修改”GPU加速方案将成为趋势,赋能更多开发者和企业释放硬件潜力,加速创新进程。对于使用Polars等其他数据处理框架的用户,NVIDIA同样提供了类似的GPU加速引擎,显示出其在推动整个数据科学生态向高性能计算迁移的决心。

网友讨论