NVIDIA驱动多模态AI:Llama 3.2 NeMo Retriever重塑信息检索新格局

多模态语言模型(VLMs)正以前所未有的方式融合视觉与文本信息,颠覆传统信息检索范式。

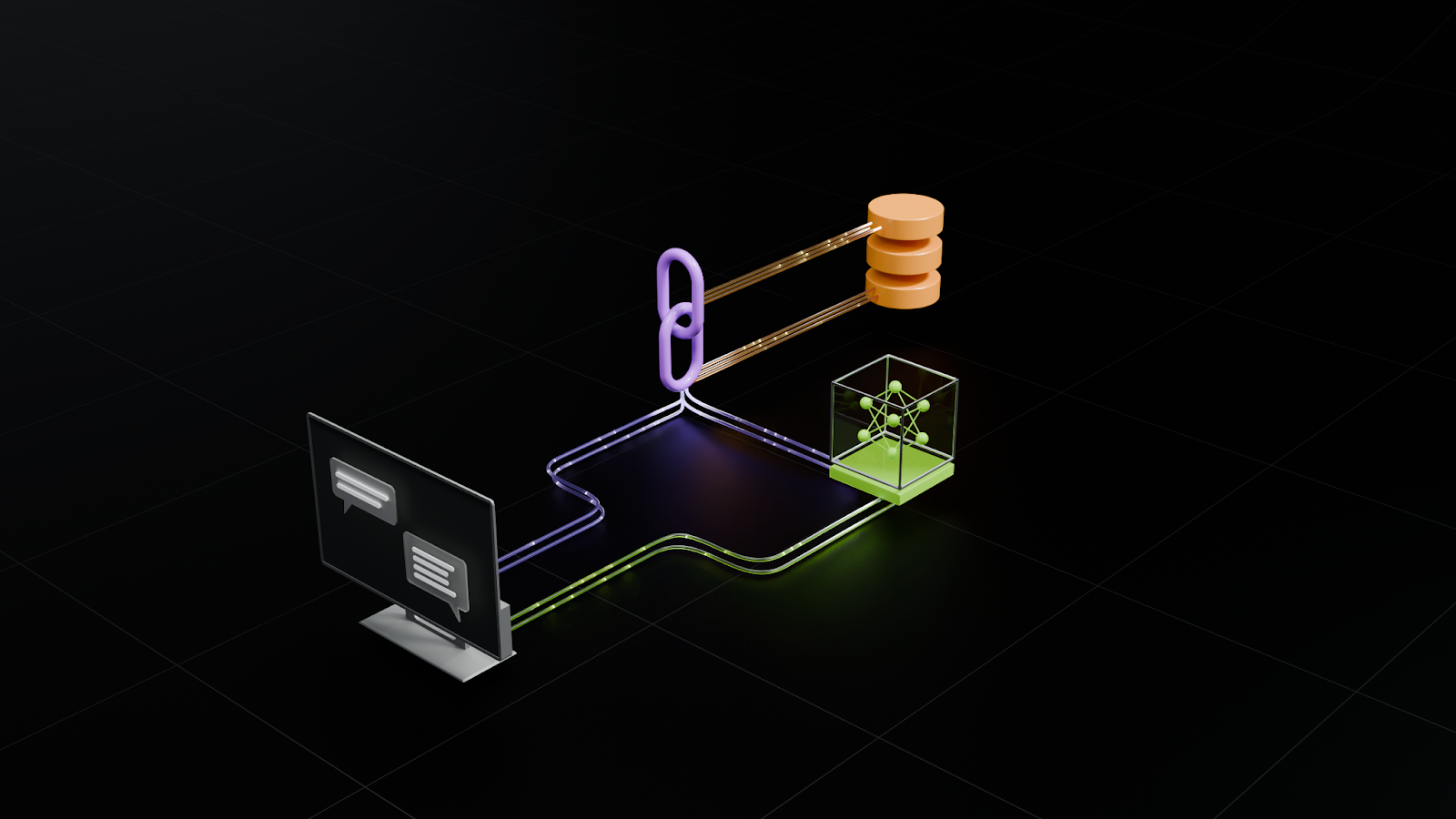

NVIDIA推出的Llama 3.2 NeMo Retriever Multimodal Embedding 1B模型,作为一款高效的小型(1.6B参数)视觉嵌入模型,显著简化了多模态检索流程。该模型能够直接处理原始图像,无需复杂的文本提取步骤,通过将图像和文本映射至共享特征空间,实现跨模态的精准检索,有效解决了传统文本检索在处理图表、图片等非文本信息时的数据丢失问题。

在多项基准测试中,NVIDIA的此款模型在检索准确性(Recall@5)上超越了同等规模的其他模型。其架构整合了SigLIP2-So400m-patch16-512视觉编码器、Llama-3.2-1B大语言模型及线性投影层,通过对比损失和硬负例挖掘进行微调,确保了文本查询与图像内容的语义对齐。这为构建大规模、高效的多模态信息检索系统奠定了坚实基础,尤其适用于产品搜索、内容推荐及多媒体数据组织等场景。

Best-in-Class Multimodal RAG: How the Llama 3.2 NeMo Retriever Embedding Model Boosts Pipeline Accuracy | NVIDIA Technical Blog

Data goes far beyond text—it is inherently multimodal, encompassing images, video, audio, and more, often in complex and unstructured formats. While the common method is to convert PDFs…

网友讨论