NVIDIA TensorRT Model Optimizer:AI模型高效量化,释放推理潜能

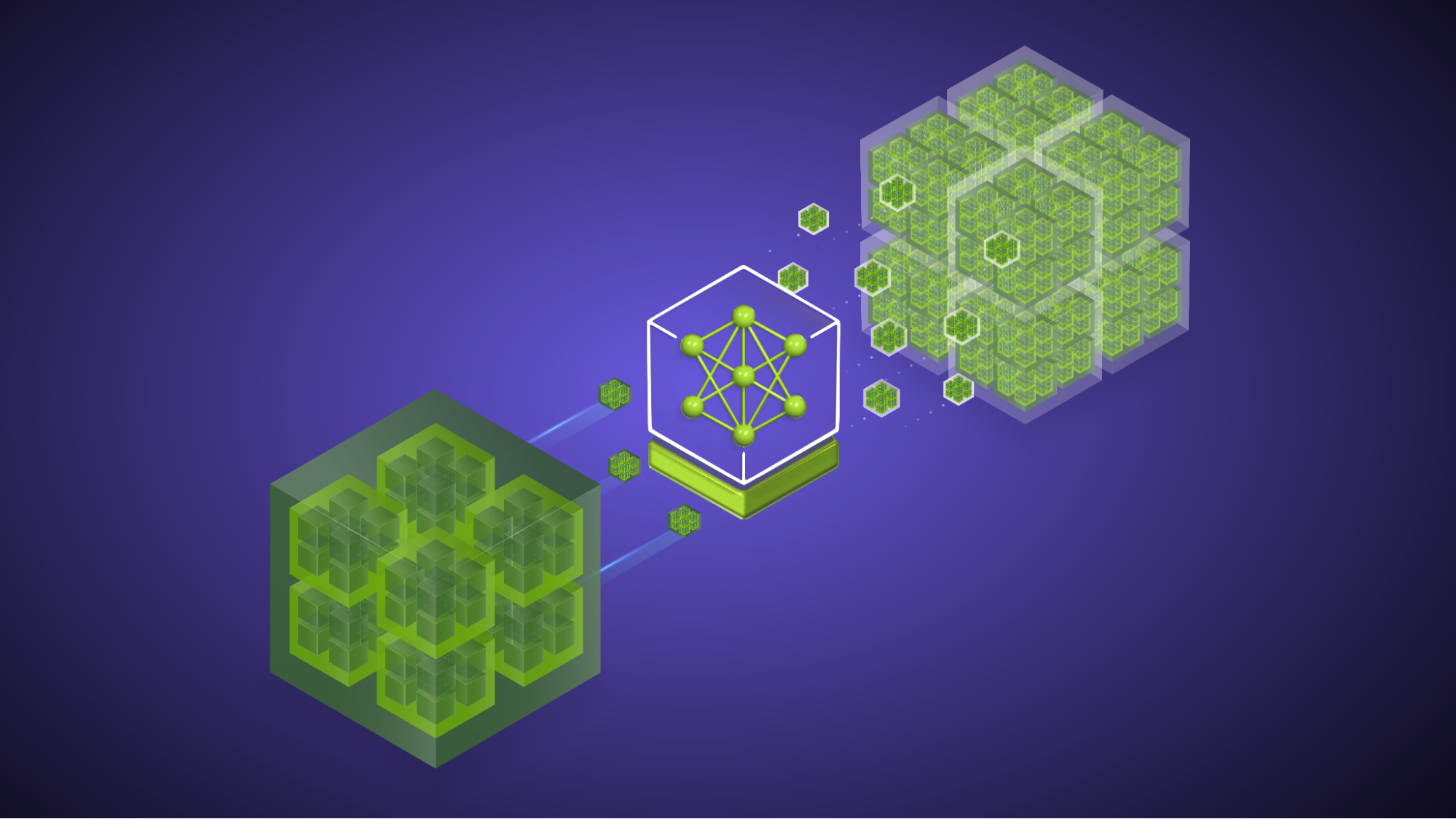

AI模型量化技术正以前所未有的速度发展,旨在显著提升推理性能并降低资源消耗。NVIDIA TensorRT Model Optimizer作为核心工具,通过其灵活的后训练量化(PTQ)框架,支持NVFP4等先进格式,并集成SmoothQuant、AWQ、AutoQuantize等校准技术,为模型压缩提供了强大支持。

该框架能够将模型从FP16/BF16甚至FP8精度量化至FP4等更低精度,从而在不进行模型重训练的前提下,大幅优化推理延迟、吞吐量和内存占用。其关键在于通过缩放因子将高精度权重映射到低精度数据类型,尽管这会降低数值的精细度,但通过先进的校准算法,能够有效缓解精度损失,保持模型的高准确性。

NVIDIA Model Optimizer PTQ框架的突出优势在于其广泛的生态系统兼容性,原生支持PyTorch、Hugging Face、NeMo和Megatron-LM等主流模型检查点,并能与TensorRT-LLM、vLLM、SGLang等推理框架无缝集成。通过NVFP4等格式的实际应用,如DeepSeek-R1模型,展现了在吞吐量提升2-3倍的同时,几乎不损失原有精度,为AI应用的成本效益优化和用户体验提升铺平了道路。

AutoQuantize等层级量化算法通过梯度敏感度分析,能够为每一层选择最优的量化配置,甚至跳过量化,实现精细化的模型压缩。虽然这可能增加计算成本,但显著提升了优化效果。最终,量化后的模型可以导出为Hugging Face检查点,便捷地部署于各类推理引擎,加速AI技术的规模化应用。

Optimizing LLMs for Performance and Accuracy with Post-Training Quantization | NVIDIA Technical Blog

Quantization is a core tool for developers aiming to improve inference performance with minimal overhead. It delivers significant gains in latency, throughput, and memory efficiency by reducing model…

网友讨论