NVIDIA NVFP4 4 位元预训练:AI 训练效率与规模化的革命性突破

NVIDIA 正将 4 位元精度计算创新扩展至大型语言模型(LLM)的预训练阶段,以 NVFP4 格式为核心,旨在大幅提升 AI 训练效率与基础设施效能。

此举标志着 LLM 发展的重要飞跃,过去 4 位元精度主要应用于推理阶段,如 NVFP4 在低延迟、高吞吐量和能效方面已展现卓越能力。如今,NVIDIA 将其引入预训练,有望重塑大规模模型训练范式,使“AI 工厂”能够处理更多 tokens,解锁下一代模型能力。

4 位元预训练通过降低内存需求、提升算力吞吐量和优化通信,使得在相同硬件上能处理更多 tokens。配合优化的量化配方,NVFP4 可以在保持与 FP8/BF16 相当的精度下,显著提高吞吐量,从而加速收敛,增加单位计算的实验次数,并支持更大规模的模型训练。

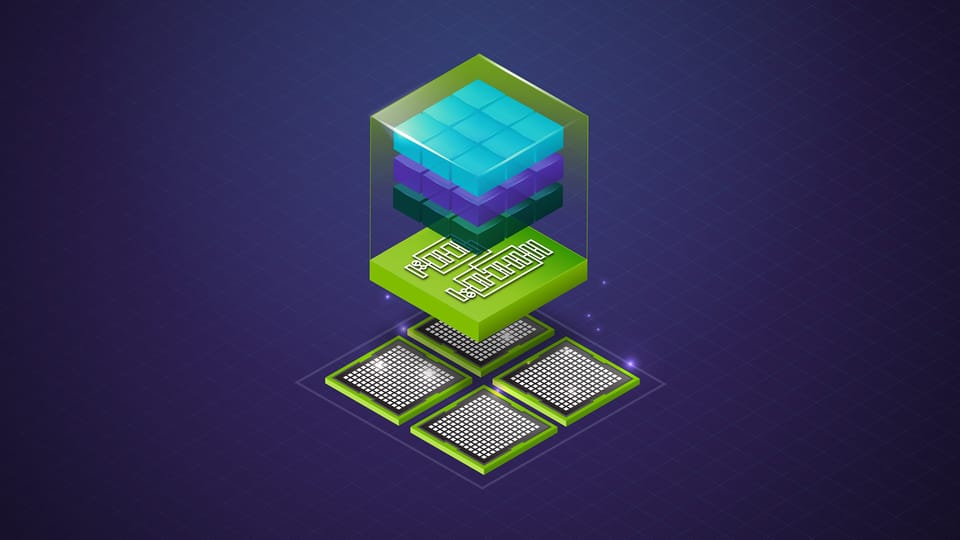

为实现 4 位元预训练,NVIDIA 开发了专门的 NVFP4 预训练配方,解决动态范围、梯度波动和数值稳定性等关键挑战。 Blackwell 架构原生支持 FP4 格式,其 GB200 和 GB300 上的 FP4 FLOPs 吞吐量,结合 NVFP4 的微块缩放和高精度 E4M3 比例因子等技术,可实现更精确的数值表示和更低的量化误差。

实验数据显示,采用 NVFP4 预训练的 120 亿参数模型在 10 万亿 tokens 数据集上的验证损失曲线与 FP8 基线模型高度吻合,且在下游任务的准确性上也表现相当。这表明 NVFP4 能够支持万亿 token 规模的 LLM 全预训练,且训练过程稳定,无明显精度损失。

网友讨论