NVIDIA NCCL 突破跨数据中心通信瓶颈,驱动大规模 AI 训练新纪元

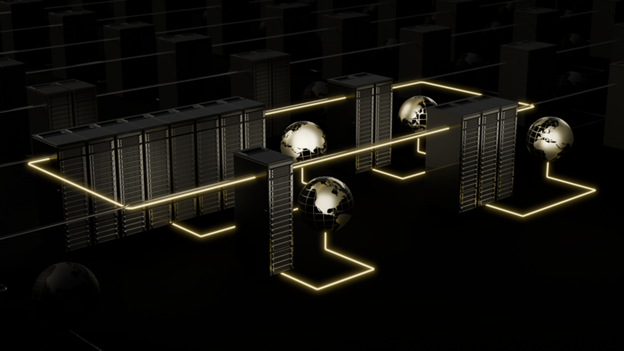

NVIDIA 的 NCCL 库现已支持跨数据中心(DC)的无缝通信,解决了 AI 训练对大规模计算能力的需求。该新功能通过引入 fabric ID 和 ncclNet API,实现了 NCCL 对网络拓扑的深度感知,从而优化跨 DC 连接性能。

NCCL 的跨 DC 功能旨在保证多 DC 连接的最佳性能,并以最小的改动支持 AI 工作负载。它支持同构网络(如 IB/RoCE)和异构网络(如 DC 内 IB/RoCE,DC 间 TCP)两种连接场景。通过 fabric ID,NCCL 能识别不同网络间的连接路径,并据此调整 Ring 和 Tree 等通信算法。例如,通过优化 Ring 算法的跨 DC 连接次数,或通过散射(scattering)机制分散 Tree 算法的根节点,有效避免了跨 DC 链路成为性能瓶颈,尤其在异构网络环境下,显著提升了通信效率。

性能调优的关键在于理解和配置 NCCL_SCATTER_XDC、NCCL_MIN/MAX_CTAS 以及与网络相关的参数,以充分利用跨 DC 连接的带宽。NCCL 的这一进展,为构建更大规模、更高效率的 AI 训练基础设施奠定了基础。

NCCL Deep Dive: Cross Data Center Communication and Network Topology Awareness | NVIDIA Technical Blog

As the scale of AI training increases, a single data center (DC) is not sufficient to deliver the required computational power. Most recent approaches to address this challenge rely on multiple data…

网友讨论