NVIDIA Gemma 3n赋能边缘AI:多模态能力与内存优化开启新纪元

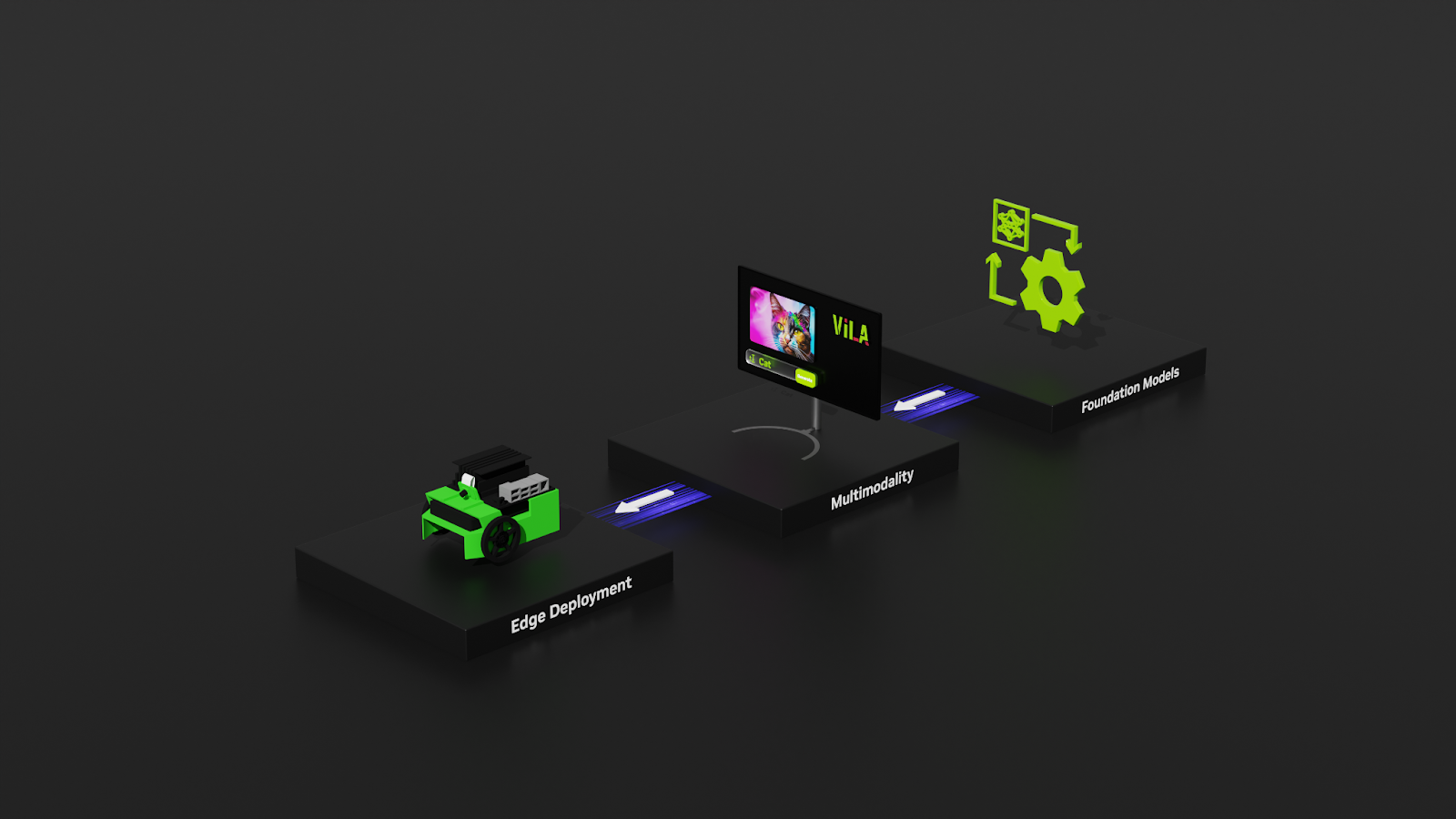

NVIDIA已宣布Gemma 3n模型现已全面支持NVIDIA RTX和Jetson平台,标志着多模态AI在边缘设备上的部署能力迈出了重要一步。此次更新集成了通用语音模型(USM)、MobileNet v4和MatFormer,为Gemma模型增加了音频处理能力,使其在文本、视觉基础上进一步拓展至听觉领域。

核心技术突破在于“Per-Lay Embeddings”,该技术显著降低了模型参数的RAM占用。例如,拥有80亿参数的Gemma 3n E4B模型,在运行时能达到与40亿参数模型相当的动态内存占用,极大地提升了在资源受限环境下的模型性能与可用性。E2B模型具备50亿参数,E4B模型拥有80亿参数,均支持32K的输入输出上下文长度,且模型文件大小控制在1.55GB和2.82GB。

此举将加速机器人技术和边缘AI的发展。NVIDIA Jetson平台能够高效运行Gemma模型,特别适合下一代机器人等边缘应用。开发者可通过Kaggle参与Gemma 3n Impact Challenge,利用该技术在可访问性、教育、医疗、环境可持续性和危机响应等领域创造积极改变,最高可赢取10,000美元奖金。

对于Windows开发者和AI爱好者,NVIDIA RTX AI PC提供了便捷的Gemma 3n本地部署方案,可通过Ollama CLI实现。NVIDIA与Ollama合作优化了RTX GPU的性能,确保Gemma 3n等模型的加速运行。开发者还可以利用开源的NVIDIA NeMo框架,通过数据准备、高效微调(支持LoRA、PEFT等)和模型评估,对Gemma模型进行定制化开发,以适应企业特定数据需求,从而实现端到端的高精度模型训练。

NVIDIA通过支持Gemma等开放模型,积极推动AI透明度和社区协作,旨在促进AI安全与韧性的共享。开发者可在NVIDIA API Catalog上使用NVIDIA加速平台体验Gemma 3n E4B。

网友讨论