KANs vs MLPs:神经网络的还原论与整体论哲学思辨

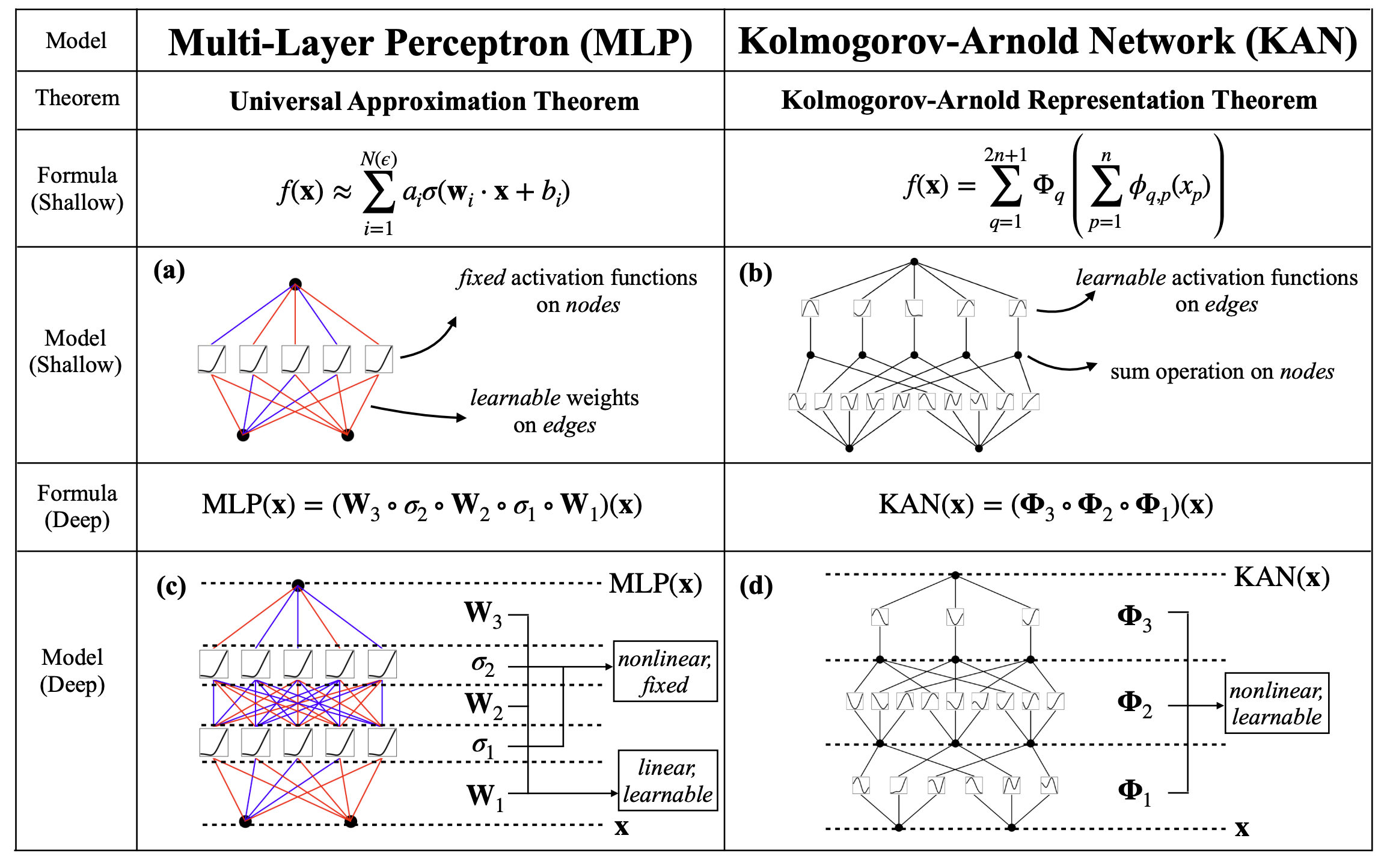

Kolmogorov-Arnold Networks (KANs)的提出,标志着神经网络研究领域的一次重要哲学反思。与传统的多层感知器(MLPs)不同,KANs在设计理念上更倾向于还原论,而MLPs则更侧重整体论。

KANs的核心在于其可学习的激活函数,这使得网络的“原子”单元本身具有复杂性,而网络的连接方式则力求简洁。通过剪枝等技术,KANs旨在构建出结构清晰的计算图。这种“复杂单元,简单连接”的模式,与科学研究中基于基本原理的还原性思维高度契合。例如,将物理定律如胡克定律(F=kx)转化为神经网络时,KANs凭借其灵活的激活函数能更直观地映射。相反,MLPs的优势在于简单的固定激活函数与复杂的连接模式相结合,其强大能力体现在整体的涌现行为,这更符合整体论的视角,在处理视觉和语言等非科学性任务上展现出卓越的有效性。

从科学研究的本质来看,还原论一直是主导性的思维方式。KANs的结构设计,尤其是在解释性和可解释性方面,使其在描述具有明确物理规律或数学公式的数据生成过程时,比MLPs更具潜力。这并非否定MLPs的价值,而是指出在特定领域(如科学定律的建模)KANs可能提供更符合科学范式的工具。然而,正如“没有免费的午餐”所言,KANs的科学导向也意味着它们可能在其他非科学领域不如MLPs。未来的研究需要通过理论与实证相结合,进一步明确KANs与MLPs各自的优势边界。

Philosophical thoughts on Kolmogorov-Arnold Networks | Ziming Liu

A simple, whitespace theme for academics. Based on [*folio](https://github.com/bogoli/-folio) design.

网友讨论