Dynamo 0.4重塑LLM部署:性能翻倍,成本优化,弹性升级

Dynamo 0.4的发布标志着大型语言模型(LLM)部署进入新纪元,其核心价值在于大幅提升性能、优化成本并增强可观测性与弹性。

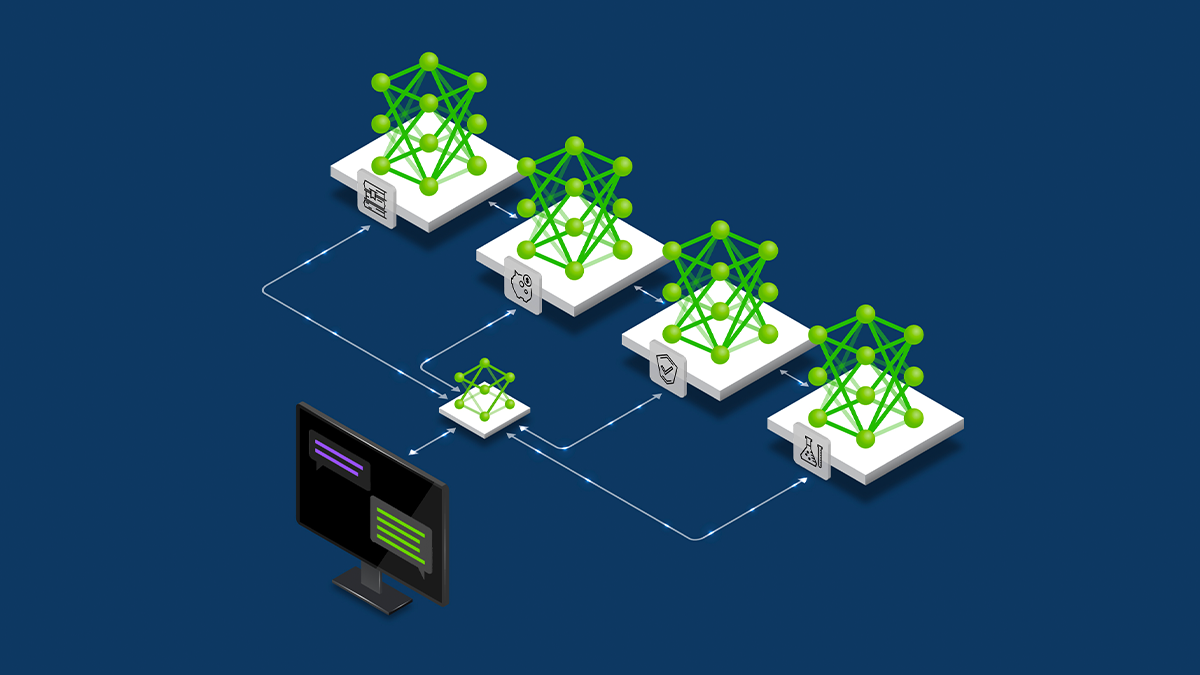

Dynamo 0.4通过解耦预训练(Prefill)与解码(Decode)阶段,实现了在NVIDIA Blackwell平台上的性能飞跃。具体而言,使用GPT-OSS-120B模型在NVIDIA B200上,处理长序列输入时交互速度提升了4倍,而DeepSeek-R1 671B模型在NVIDIA GB200 NVL72上的吞吐量则提高了2.5倍,且推理成本未增。这一成果得益于其创新的“解耦服务”架构,允许根据各阶段特定需求灵活分配GPU资源和模型并行度,从而显著提升整体效率。

为简化大规模部署的复杂性,Dynamo 0.4引入了AIConfigurator工具,能够根据模型特性、GPU预算和目标服务水平目标(SLO)推荐最优的解耦配置和模型并行策略。此外,其SLO驱动的自动扩缩容引擎Planner,通过预测流量模式和分析部署行为,确保在满足严格性能指标(如首次响应时间TTFT和交互延迟ITL)的同时,实现GPU资源的精细化利用,避免过度或不足配置。该引擎已原生集成Kubernetes,便于现有容器化基础设施的部署。

在可观测性方面,Dynamo 0.4实现了关键性能指标(如请求速率、延迟、GPU利用率等)的实时收集与展示,支持Prometheus和Grafana等开源工具,便于故障诊断和性能优化。同时,其增强的弹性机制,特别是“在途请求重路由”和“早期故障检测”,能在硬件或软件组件短暂失效时,无缝转移请求至健康节点,并快速响应故障信号,最大程度减少服务中断和用户请求失败,确保了大规模分布式推理的稳定运行。

Dynamo 0.4 Delivers 4x Faster Performance, SLO-Based Autoscaling, and Real-Time Observability | NVIDIA Technical Blog

The emergence of several new-frontier, open source models in recent weeks, including OpenAI’s gpt-oss and Moonshot AI’s Kimi K2, signals a wave of rapid LLM innovation. Dynamo 0.4, available today…

网友讨论