DeepConf:LLM推理效率与准确率的双重飞跃,实现“精思考”

由Yichao Fu等研究人员提出的DeepConf(Deep Think with Confidence)方法,旨在通过一种测试时推理技术,显著提升大型语言模型(LLMs)的推理能力。该方法不依赖于额外的模型训练,而是利用模型内部的对数概率来计算局部置信度分数,从而区分并优化推理路径。DeepConf支持离线和在线两种模式:离线模式通过过滤和置信度加权多数投票来优化结果;在线模式则能动态终止低置信度的推理过程,实现实时效率提升。

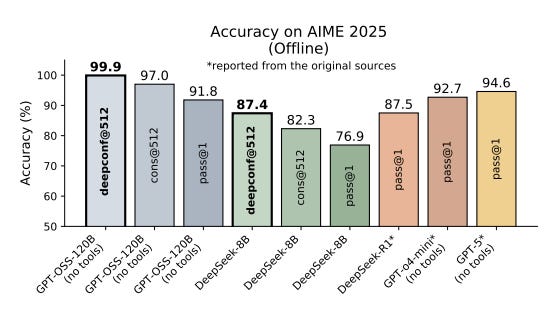

DeepConf的核心价值在于其解决当前LLM推理中的效率瓶颈。与“自相一致性”等依赖于大规模生成来提升准确率的方法不同,DeepConf通过精细化评估推理路径的质量,实现了在显著减少计算量(最多可达84.7%的token削减)的同时,大幅提升了模型在复杂推理任务上的准确性。例如,在AIME 2025基准测试中,GPT-OSS-120B模型通过DeepConf达到了99.9%的准确率,远超传统方法。这为LLM在实际应用中的大规模部署提供了更具经济可行性的路径,标志着从“多思考”到“精思考”的范式转变。

Deep Think with Confidence

DeepConf: Scaling LLM Reasoning with Confidence, Not Just Compute

网友讨论