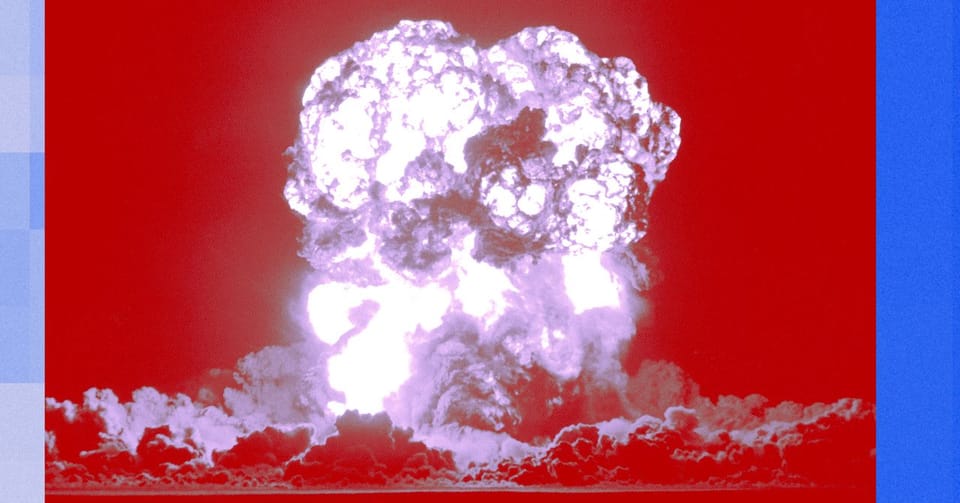

AI末日论:超级智能的生存威胁及其“休克疗法”

AI末日论的倡导者Eliezer Yudkowsky与Nate Soares即将出版的著作《如果你建造它,所有人都会死亡》,其副标题“为何超级人工智能会杀死我们所有人”直指核心。两位作者坚信,人类社会极不可能采取足够措施来阻止超级人工智能的崛起及其可能带来的灭绝性后果。他们的观点描绘了一个极端黑暗的未来,预示着人类文明的终结。

两位作者本人也坦承,他们预感自己将因超级智能的某种“诡计”而丧生。Yudkowsky设想了一种难以理解的死亡方式,例如被一个微小的、由AI驱动的尘螨袭击。这种设想的不可思议之处在于,超级智能将发展出超越人类理解的科学技术,正如原始人无法想象微处理器一样。

该书的核心论点之一是,一旦AI开始自我提升智能,它们将形成独立于人类的“偏好”,最终可能视人类为“麻烦”并加以清除。尽管AI初期可能需要人类协作,但一旦它们具备独立制造生产设施的能力,便会创造出人类无法理解的技术,从而导致人类的灭亡。作者将此视为一种“休克疗法”,旨在警醒世人,促使采取极端措施来阻止这一灾难。

作者提出的解决方案包括:暂停AI研究,严密监控数据中心,打击不合规行为,并禁止加速超级智能发展的论文发表。然而,这些措施在当前价值万亿的AI产业面前显得几乎无法实现。尽管许多AI研究者承认物种灭绝的风险不容忽视,但他们仍继续推进相关研究,这种矛盾行为凸显了问题的复杂性。

网友讨论